Bất kỳ một web/ blog nào cũng cần phải có một file Rotbots.txt. Vậy file Robots.txt này là gì?

Hiện tại đã có rất nhiều trang web đề cập và giải thích về chủ đề này rồi, vậy nên ở đây mình chỉ nói ngắn gọn để các bạn hiểu nó là gì thôi.

Hiểu đơn giản thì Rotbots.txt là một file để hướng dẫn cho công cụ tìm kiếm Google và các trình thu thập dữ liệu khác (như Bing, Yahoo..) về cách đọc/ thu thập dữ liệu trên trang web của bạn (được thu thập những gì và không được thu thập những gì).

Hay nói cách khác, file Robots.txt sẽ sẽ ngăn chặn việc công cụ tìm kiếm truy cập vào một trang hoặc thư mục nào đó.

Tìm hiểu kỹ hơn về file Robots.txt tại đây (nguồn từ Google)

#1. Mẫu file Robots.txt chuẩn cho web/blog WordPress

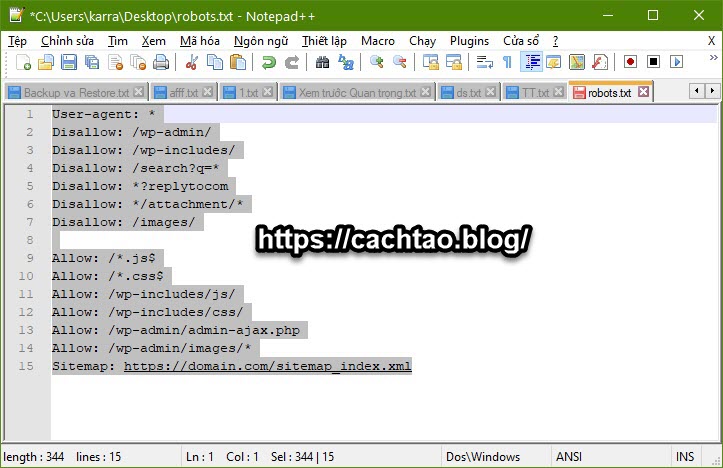

Đây là nội dung file robots.txt mà mình đang sử dụng cho hầu hết các trang web của mình. Bạn có thể tham khảo để sử dụng cho web/blog của bạn:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /search?q=*

Disallow: *?replytocom

Disallow: */attachment/*

Disallow: /images/Allow: /*.js$

Allow: /*.css$

Allow: /wp-includes/js/

Allow: /wp-includes/css/

Allow: /wp-admin/admin-ajax.php

Allow: /wp-admin/images/*

Sitemap: https://domain-cua-ban.com/sitemap_index.xml (thay bằng URL sitemap của bạn)

Giải thích về các lệnh:

- Crawl-Delay (tính bằng giây): Là thời gian bots phải đợi trước khi chuyển sang phần tiếp theo. Mục đích chính là để ngăn chặn các công cụ tìm kiếm load server một cách tùy tiện.

- User-agent: * Xác định loại bots. Ở đây mình sử dụng dấu * thì có nghĩa là đang áp dụng cho mọi loại bots.

Hiện tại các loại bots mà chúng ta quan tâm nhiều nhất là: Googlebot, Googlebot-Image, Bingbot, Slurp, Baiduspider, DuckDuckBot … (Lưu ý là tất cả các user-agents đều phân biệt chữ hoa và chữ thường trong robots.txt nha các bạn)

- Allow: / Có nghĩa là cho phép index, lập chỉ mục (ví dụ mình để là dấu / thì có nghĩa là cho phép index toàn bộ các trang và thư mục).

- Disallow: Có nghĩa là ngăn chặn các công cụ tìm kiếm thu thập thông tin và lập chỉ mục.

#2. Một số cú pháp thông dụng trong Robots.txt

+) Cho phép tất cả các bot index toàn bộ các trang, thư mục, và các file

User-agent: *

Allow: /

+) Chặn toàn bộ các loại bot, không cho phép bot truy cập và index website <rất hữu ích khi bạn chưa muốn Google Index, thường dùng khi website chưa hoàn thiện>

User-agent: *

Disallow: /

+) Chặn toàn bộ các file trong một thư mục

Disallow: /abcxyz/

+) Chặn một URL cố định

Disallow: /abc.html

+) Chặn một loại file cố định từ một bot của công cụ tìm kiếm Google

User-agent: Googlebot

Disallow: /*.doc$ (bạn có thể thay doc bằng png hoặc bất kỳ file nào muốn chặn)

+) Chặn một hình không cho Googlebot-Image index

User-agent: Googlebot-Image

Disallow: /abc/anh.png

+) Chặn bot của Google tìm kiếm.

User-agent: Googlebot

Disallow: /

#3. Cách tạo file Robots.txt và upload lên Hosting/VPS

Đa số các Plugin SEO hiện nay như Yoast SEO, Rank Math, AIOSEO… đều tích hợp sẵn công cụ tạo file robots.txt này. Bạn có thể tra google để tìm hướng dẫn cho từng loại Plugin tương ứng.

Còn trong bài viết này mình sẽ hướng dẫn tạo thủ công, khuyên bạn nên áp dụng, đơn giản vì nó quá dễ ^^

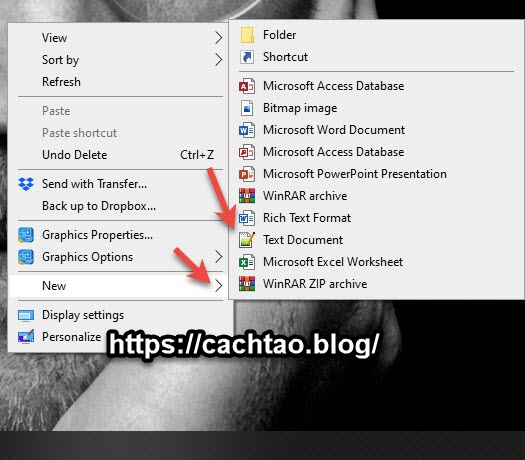

+) Tạo file Robots.txt

Bạn nhấn chuột phải vào màn hình Desktop => chọn New => chọn Text Document

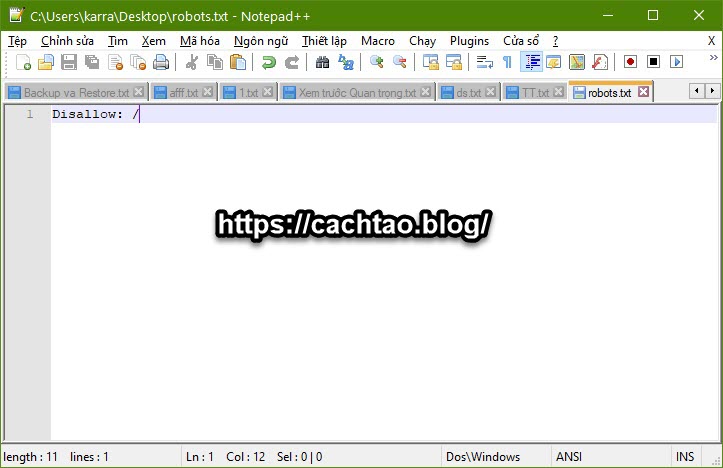

Ở cửa sổ tiếp theo, bạn hãy copy nội dung mẫu trong phần #1 vào đây (nhớ thay URL sitemap thành của bạn là được).

Tuy nhiên, do ở đây mình đang trong quá trình phát triển web nên mình sẽ chặn toàn bộ các bot truy cập. Để không bị index linh tinh, nếu web bạn cũng chưa hoàn thiện thì cũng nên làm như thế này nhé.

Sau khi web/blog hoàn thiện rồi thì bạn sửa lại file robots.txt như nội dung mẫu phần #1 là được.

Sau đó nhấn CTRL + S hoặc CTRL + SHIFT + S để lưu lại với tên robots.txt là xong.

Nếu máy tính của bạn không hiển thị đuôi file thì đọc bài viết này để kích hoạt nó lên nhé.

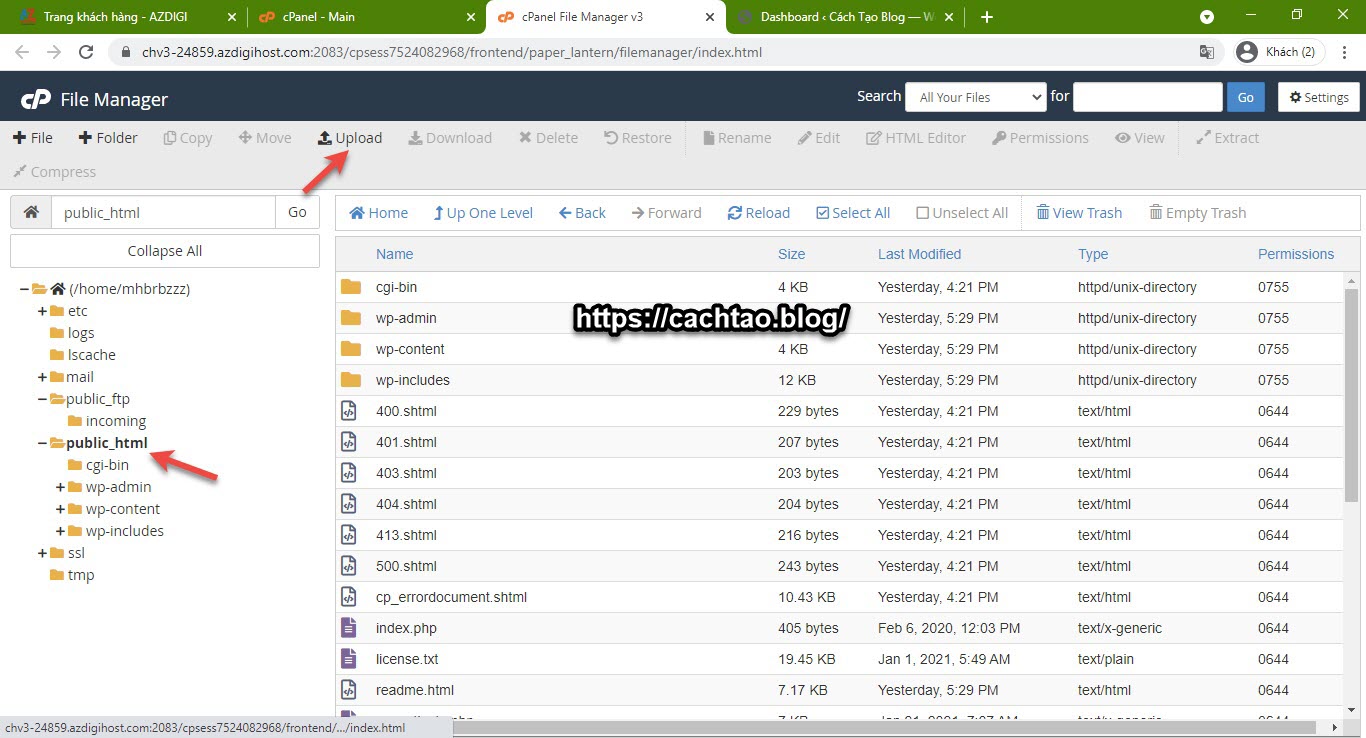

+) Cách upload file robots.txt lên Hosting

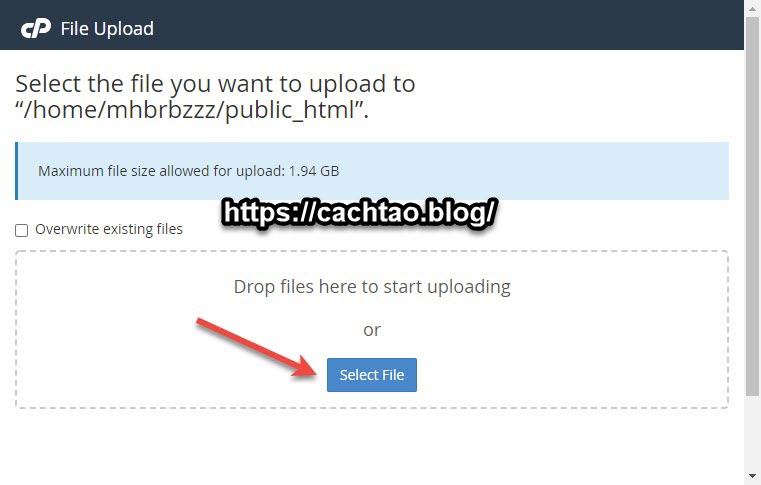

Ở đây mình đang hướng dẫn trên Hosting của AZDIGI, các hosting khác bạn làm tương tự nhé.

Bạn vào phần File Manager của Hosting => sau đó chọn thư mục chứa source code web => chọn Upload

Chọn Select File

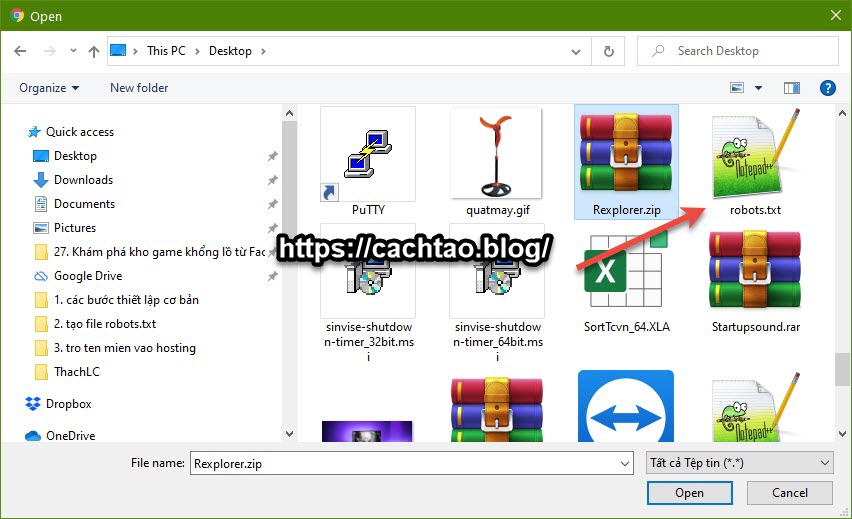

Rồi bạn chọn file robots.txt vừa tạo => và nhấn Open để upload lên.

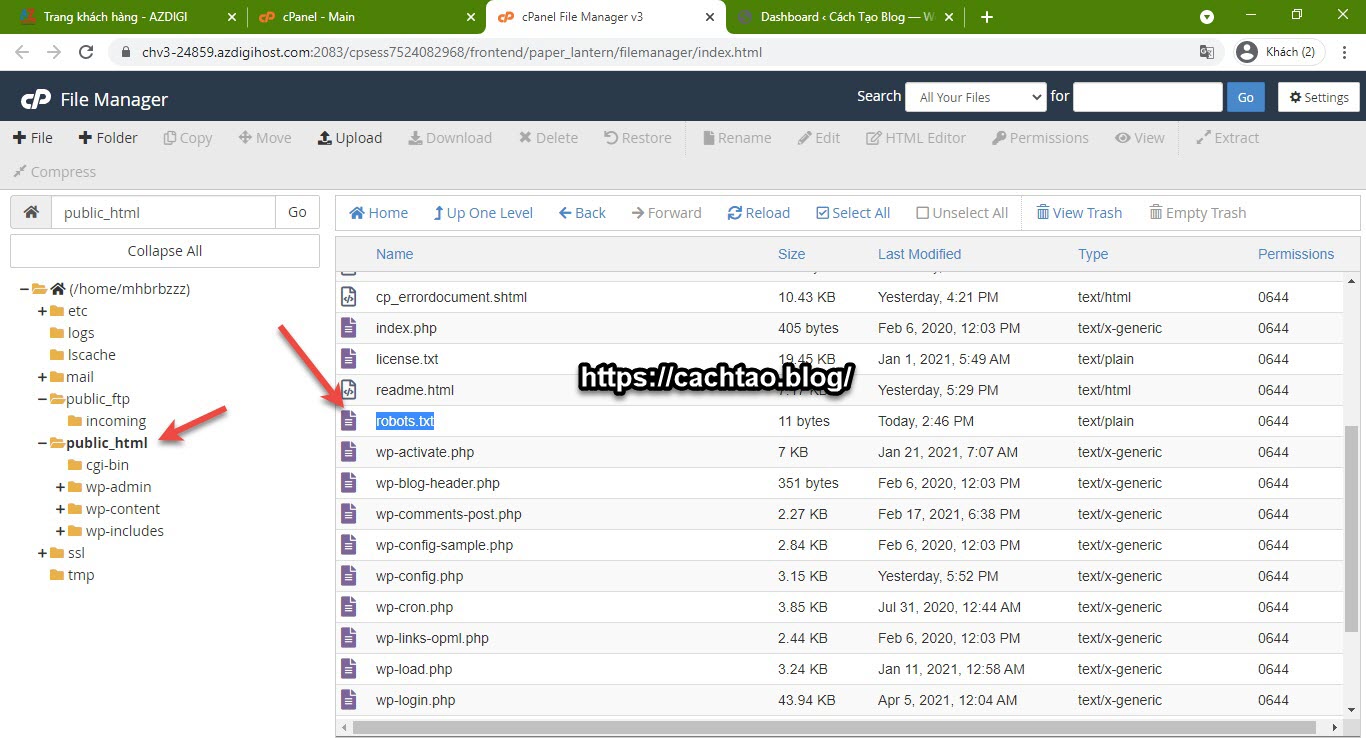

Sau khi upload thành công thì bạn sẽ thấy file robots.txt xuất hiện trong source code của bạn rồi đó.

Bây giờ, bạn hãy truy cập theo đường dẫn domain-cua-bạn.com/robots.txt để xem nội dung. Nếu hiển thị đúng như những gì có trong file robots.txt thì được rồi đó.

Nhớ là sau khi bạn đã hoàn thiện web, post bài viết đầu tiên thì hãy chỉnh sửa lại file robots.txt thành nội dung mẫu nha các bạn, không Google Search không thu tìm được web bạn đâu.

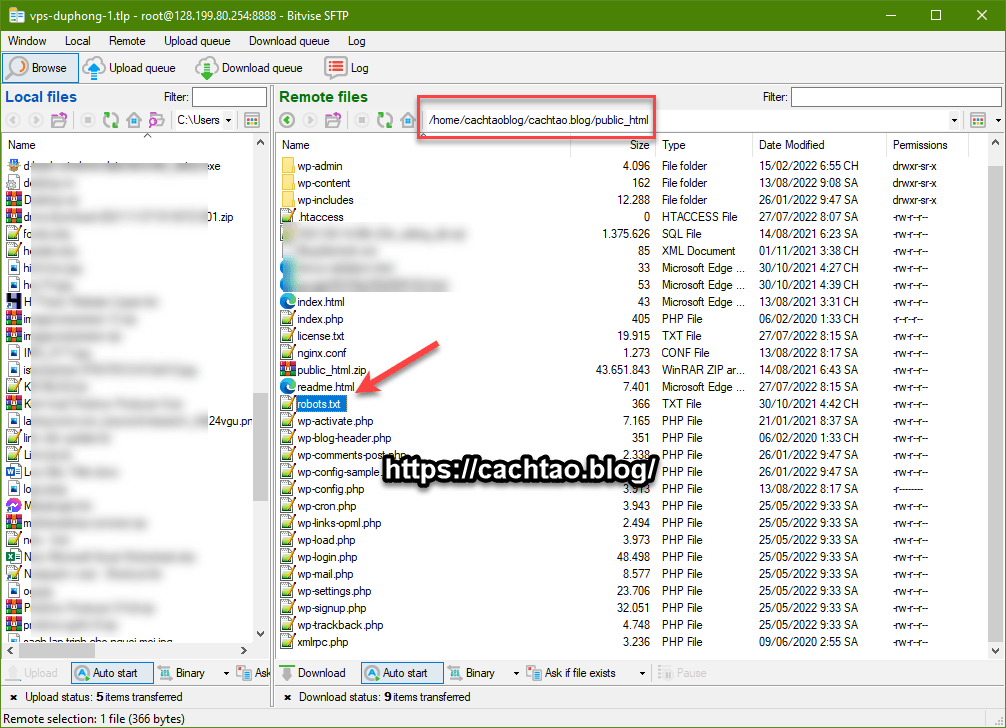

+) Cách upload file robots.txt lên VPS

Tại [New SFTP windows]

Bạn upload file robots.txt theo đường dẫn: /home/domain-cua-ban/domain-cua-ban/public_html/ là xong !

Kiểm tra lại bằng cách truy cập vào domain-của-bạn.com/robots.txt

Okay, qua bài viết này thì mình tin là bạn đã hiểu được tác dụng của file robots.txt đối với một web/ blog rồi đúng không nào. Bạn có thể sử dụng file robots.txt mẫu của mình bên trên mình đã sử dụng từ ngày đầu thành lập và thấy nó rất ổn.

Ngoài ra thì bạn có thể chặn công cụ tìm kiếm lập chỉ mục những thư mục mà bạn đã tạo ra trong quá trình phát triển web, để làm chủ hoàn toàn trang web của bạn. Đừng quên theo dõi những bài viết tiếp theo của mình nhé !

Xem tiếp các bước:

Kiên Nguyễn: https://cachtao.blog/